Extracto del artículo publicado en el nº 103 de la Revista Ábaco

Ramón López de Mántaras Badia

Profesor de Investigación Instituto de Investigación en Inteligencia Artificial (CSIC)

En este texto llevo a cabo, en primer lugar, resumen de mi propia trayectoria profesional y, en segundo lugar, un breve repaso del campo de la Inteligencia Artificial (IA). Lo primero lo realizo no por vanidad, sino para que el lector pueda calibrar con propiedad quién y desde dónde se realiza lo segundo, además de porque constituye un ejemplo concreto de lo que es y lo que hace un investigador en Inteligencia Artificial y porque modestamente forma parte del desarrollo de la Inteligencia Artificial en España.

Mi trayectoria científica en el campo de la inteligencia artificial

Actualmente soy Profesor de Investigación del CSIC en el Instituto de Investigación en Inteligencia Artificial. Soy Doctor en Física por la Universidad Paul Sabatier de Toulouse, “Master of Science” en Informática por la Universidad de California-Berkeley y Doctor en Informática por la Universidad Politécnica de Cataluña. Fui Profesor Titular de la Facultad de Informática de Barcelona y Catedrático de la Universidad Pierre et Marie Curie de París. Soy uno de los pioneros de la IA en España, campo en el que tengo publicaciones desde 1976 resultado de mi Tesis Doctoral en Toulouse sobre aprendizaje automático aplicado al reconocimiento táctil de objetos mediante una mano robótica antropomórfica. Formo parte del comité de redacción de más de veinte revistas internacionales y he sido miembro de comités científicos en más de 250 congresos relacionados con la inteligencia artificial. Fui Editor-in-Chief de Artificial Intelligence Communications, la revista europea de Inteligencia Artificial, y Associate Editor de Artificial Intelligence Journal, la revista más prestigiosa en el campo de la IA. Soy autor o co-autor de unas 250 publicaciones científicas y del libro Approximate Reasoning Models, publicado por Ellis Horwood en su Artificial Intelligence Series. He recibido, entre otros, los siguientes reconocimientos: Premio “Ciudad de Barcelona de Investigación” en 1982, Premio “Swets & Zeitlinger Award” de la Asociación Internacional de Informática Musical en 1997, Premio “Robert S. Engelmore Award” de la Asociación Americana de Inteligencia Artificial en 2011, Premio Nacional de Informática de la Sociedad Científica Informática de España en 2012, Premio “Distinguished Service Award” de la Asociación Europea de inteligencia Artificial (EurAI) en 2016, Premio “Donald E. Walker Award” de IJCAI en 2017 y Premio Nacional de Investigación “Julio Rey Pastor” en Matemáticas y Tecnologías de la Información y las Comunicaciones en 2018. Soy miembro de honor de EurAI (Asociación Europea de Inteligencia Artificial) y miembro numerario del Instituto de Estudios Catalanes. Actualmente investigo en razonamiento y aprendizaje por analogía y en técnicas de aprendizaje por experiencia y transferencia.

Mi tesis doctoral en Francia, que leí en junio de 1977, fue una de las primeras tesis en Europa sobre aprendizaje automático aplicado a la Robótica y en el tema particular del reconocimiento táctil de objetos sólidos, por lo que sé no había nada anterior a nivel internacional. Los artículos en revistas y en el principal congreso internacional sobre Pattern Recognition, donde tuve la oportunidad de publicar, tuvieron un alto impacto en aquel momento. Por este motivo puedo afirmar que me siento orgulloso de mi tesis.

Posteriormente, en colaboración con mis estudiantes de Doctorado principalmente, hay resultados, de mediados y finales de la década de 1980, de los que estoy orgulloso en el campo de los Sistemas Expertos, y en particular en aplicaciones a la medicina, algunos de las cuales se estuvieron usando en diversos hospitales en España. Uno de estos trabajos recibió el premio europeo del mejor trabajo publicado en Inteligencia Artificial del año 1987, otorgado por la Asociación Europea de Inteligencia Artificial con el patrocinio de la empresa Digital.

Posteriormente, en 1991 publiqué en la revista Machine Learning un artículo sobre un nuevo criterio, basado en Teoría de la Información, de selección de atributos en aprendizaje inductivo de árboles de decisión que fue y sigue todavía siendo muy citado. Este criterio de selección de atributos también fue incluido en el paquete de software para “Data Mining” AC2, comercializado por la firma francesa ISOFT. También merece la pena mencionar que se describe y cita en dos de los libros de texto más prestigiosos en IA: en el libro Machine Learning de T. Mitchell, y en el libro Pattern Classification escrito por R. Duda, P. Hart, D. Stork y se enseña en múltiples cursos de Machine Learning en muchas universidades de todo el mundo.

A mediados de los 90 junto con otro de mis doctorandos hicimos aportaciones, que también han sido muy citadas, al Razonamiento basado en Casos. Esos trabajos, además, fueron de los pioneros en Europa en este tema.

A finales de los 90, junto con otros co-autores, publiqué un artículo que describía un sistema de Razonamiento Basado en Casos aplicado a la síntesis de música expresiva que recibió el “Swets & Zeitlinger Best Paper Award” de la International Conference on Computer Music en 1997. En este trabajo fuimos los primeros en conseguir generar interpretaciones musicales prácticamente indistinguibles de interpretaciones humanas. Este trabajo es también uno de los más citados a lo largo de mi carrera. También se hizo eco de nuestro resultado el Sunday Times y la reputada revista de divulgación alta científica New Scientist, además de otros medios de comunicación de ámbito nacional.

Posteriormente, en la primera década de este siglo XXI, junto con otra estudiante de doctorado y otros colaboradores, desarrollamos nuevos algoritmos para el aprendizaje y razonamiento colaborativo en grupos de robots que intentan alcanzar objetivos en entornos no deterministas y en situaciones en las que hay competidores que intentan dificultar la consecución de dichos objetivos. Internacionalmente el ámbito estándar para probar estos algoritmos es el fútbol robótico. Los resultados obtenidos, en colaboración con la prestigiosa Universidad Carnegie-Mellon fueron excelentes y se incorporaron en el equipo de fútbol robótico CMDash de dicha Universidad, que compitió con notable éxito (CMDash fue el tercer clasificado) en la Robocup de 2007. Además, esta contribución dio lugar a una publicación en la revista Artificial Intelligence, una de las más prestigiosas en el ámbito de la IA. Actualmente sigo trabajando en uno de los aspectos más importantes de Machine Learning, concretamente en el problema del “Transfer Learning” en el contexto de la robótica humanoide. Se trata de conseguir que un robot pueda transferir habilidades previamente aprendidas en una tarea concreta para realizar otra tarea distinta aunque relacionada. Uno de los resultados conseguidos, en colaboración con investigadores de otros países, consiste en un robot que una vez ha aprendido (mediante aprendizaje por refuerzo) a mantener en equilibrio un doble péndulo invertido transfiere lo aprendido para aprender a andar de forma robusta. El algoritmo propuesto combina el aprendizaje por refuerzo con el aprendizaje y razonamiento basado en casos. Este resultado también se publicó en la revista Artificial Intelligence. Dada la, en mi opinión, crucial importancia para progresar hacia la IA general del Transfer Learning, estoy orgulloso de poder contribuir a este complejo objetivo de la IA general. Mi trabajo más reciente, que también será publicado en la revista Artificial Intelligence, es una contribución al razonamiento analógico cualitativo en robots autónomos donde se demuestra que la aproximación cualitativa permite tomar decisiones más rápidas y en consecuencia mejorar la colaboración entre robots. Todavía es pronto para evaluar el impacto de este último trabajo, pero estoy orgulloso del resultado obtenido.

La Inteligencia Artificial: pasado, presente y futuro

A continuación, expongo algunos de los acontecimientos más importantes que, a mi juicio, se han producido en relación con la Inteligencia Artificial, para hacer después algunas consideraciones sobre el presente y el futuro.

- 1943: McCulloch y Pitts propusieron un modelo simplificado de neurona en base a la idea de que una neurona es esencialmente una unidad lógica. En base a lo que ya se sabía entonces sobre el reforzamiento de las sinapsis entre neuronas biológicas, se vio que estas redes neuronales artificiales se podían entrenar para aprender funciones que relacionaran las entradas con las salidas mediante el ajuste de los pesos que sirven para ponderar las conexiones entre neuronas. Fue el trabajo seminal de la IA conexionista, es decir de las Redes Neuronales Artificiales que tanto éxito tienen ahora.

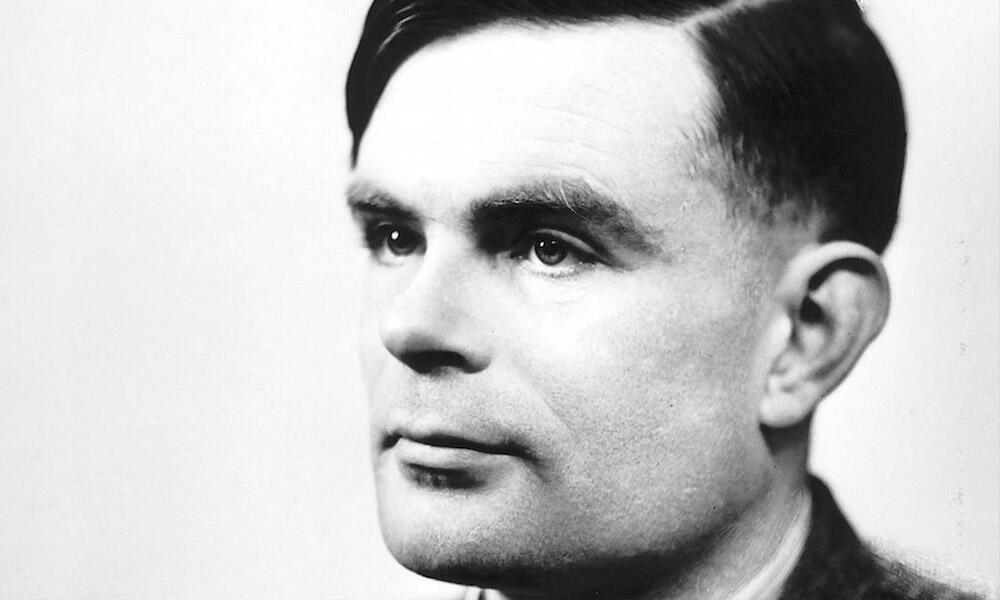

- 1950: Alan Turing, en su artículo “Computing machinery and intelligence”, publicado en 1950 en la revista Mind, defendía la idea de que los ordenadores podían llegar a mostrar comportamientos inteligentes. En este artículo lo de menos, de hecho, es su famoso “Test de Turing”. En mi opinión el artículo contiene ideas mucho más interesantes, precursoras de técnicas que tardaron años en aparecer en la IA, como por ejemplo el aprendizaje por refuerzo, e incluso algo muy reciente en IA que se conoce como “Developmental Learning”.

- 1955: En el marco de la “Western Joint Computer Conference”, en Los Angeles, hubo una sesión dedicada a máquinas que aprenden titulada: “Learning Machines”. Sin duda fue la primera vez que un congreso dedicaba toda una sesión a la IA, y en particular al aprendizaje automático. En dicha sesión Allen Newell esbozó la posibilidad de programar ordenadores de forma que jugaran al ajedrez al estilo humano, es decir, incorporando conceptos tales como la descomposición de un objetivo en sub-objetivos más simples, criterios para detener el proceso de búsqueda del siguiente movimiento a efectuar, y el uso de funciones de evaluación de los movimientos para seleccionar un movimiento “suficientemente bueno” de acuerdo con el concepto de “satisficing solution” propuesto por Herbert Simon en el marco de sus investigaciones sobre “bounded rationality” en economía (que años más tarde le hicieron merecedor del Premio Nobel en Economía). Es un hito importante porque el concepto de “satisficing solution” está en la base de lo que se conoce como búsqueda heurística, una técnica absolutamente fundamental en IA.

- 1956: Dartmouth College Summer Conference. Organizada por John McCarthy, Marvin Minsky y Claude Shanon, donde se acuña el término “Inteligencia Artificial”; también estaban otras personas destacadas: Nathaniel Rochester, Arthur Samuel, Alex Bernstein, Oliver Selfridge, Ray Solomonoff, Allen Newell, y Herbert Simon. Viene a ser el “nacimiento” oficial de la IA.

- 1956: En la reunión de Dartmouth Newell y Simon presentaron “Logic Theorist”, un programa capaz de demostrar algunos (no todos) teoremas de lógica proposicional del libro Principia Mathematica de Russell y Whitehead. Diríamos que fue el primer programa de demostración automática de teoremas. “Logic Theorist” ya demostró la potencia de usar heurísticas para resolver problemas.

- 1958: John McCarthy, entones en el MIT, inventa el lenguaje de programación LISP, que se impuso como el lenguaje por excelencia en la comunidad de la IA y sentó las bases de otros muchos lenguajes de programación funcional posteriores; y hasta hoy día.

- 1959: Arthur L. Samuel desarrolló el primer programa capaz de jugar a un juego de tablero a un nivel avanzado. Se trataba del juego de checkers, muy similar a lo que en España llamamos Damas. La gran contribución de Samuel fue que mejoraba su nivel de juego ajustando los pesos de las variables de una función heurística de evaluación de los movimientos que tenía en cuenta el valor de cada pieza y la posición de las piezas en el tablero, en particular la movilidad de las piezas o el control del centro del tablero. Además, aprendió jugando contra una copia se sí mismo en base a una técnica precursora del aprendizaje por refuerzo actual. Unos pocos años más tarde el programa de Samuel llegó a vencer a algunos maestros de checkers y tuvo una importante repercusión en los medios de comunicación.

- 1963: Robinson inventa el “principio de resolución”. Este principio consiste básicamente en una lógica causal basada en una única regla de inferencia muy sencilla pero que permitió progresos importantes en resolución automática de teoremas.

- 1966: Joseph Weizenbaum desarrolla el programa ELIZA, que simula a un psicoterapeuta Rogeriano. El sistema se basa en una técnica sencilla de pattern matching que busca palabras clave en las respuestas del usuario de tal forma que estas palabras clave se insertan a continuación en una frase prefabricada para generar la siguiente pregunta. Cuando la palabra clave no está entre las que tiene predefinidas, cambia bruscamente de tema formulando una pregunta no relacionada con la respuesta del usuario. Sin duda el precursor de los actuales chatbots que, de hecho, cincuenta años después… ¡no son mucho mejores que ELIZA!

- 1971: Colmerauer, Roussel y Kowalski inventan el lenguaje de programación lógica PROLOG. Junto con LISP, fueron los lenguajes más usados. Actualmente se sigue usando.

- 1971: Surge el planificador STRIPS (Stanford Research Institute Problem Solver) que posibilitó que el primer robot móvil SHAKEY, desarrollado por el equipo de Charles Rosen en el SRI, planificara sus acciones para moverse en entornos con obstáculos.

- Mediados de los 70: Aparecen los primeros Sistemas Expertos: DENDRAL en el ámbito de la Química Orgánica, desarrollado por Fegenbaum, Buchanan y Leidelbergy; MYCIN en Medicina, desarrollado por Shortliffe; y PROSPECTOR en Geología, desarrollado por Hart.

- Entre mediados de los 70 y principios de los 80: Roger Schanck y varios de sus doctorandos desarrollan los primeros sistemas de procesamiento del lenguaje basados en análisis semántico de los textos. Para ello introducen conceptos como los Grafos de Dependencia Conceptual, inspirados en las redes semánticas propuestas por Woods en 1975, y los Script.

- 1979: Ross Quinlan desarrolla el sistema ID3 de aprendizaje de árboles de decisión. Una de las técnicas de aprendizaje más usadas incluso hoy día.

- Desde finales de los 70 hasta mediados de los 80: Primer “invierno” de la IA debido a que se vio que no se cumplían las excesivas expectativas que los pioneros de la IA habían levantado. No solamente no se cumplían, sino que hubo grandes fracasos en traducción automática por una parte, y por otra parte se vio que muchas técnicas de IA no “escalaban” bien cuando se pasaba de problemas “juguete” a problemas complejos del mundo real. También contribuyeron al dicho “invierno” las duras críticas de varios filósofos de la mente, como John Searle o Hubet Dreyfus, mostrando, a mi entender con razón, las limitaciones de que únicamente la manipulación sintáctica de símbolos no podía dar lugar a verdadera inteligencia.

El artículo completo está disponible en el número 103 de la Revista Ábaco.

Pincha en el botón inferior para adquirir la revista.